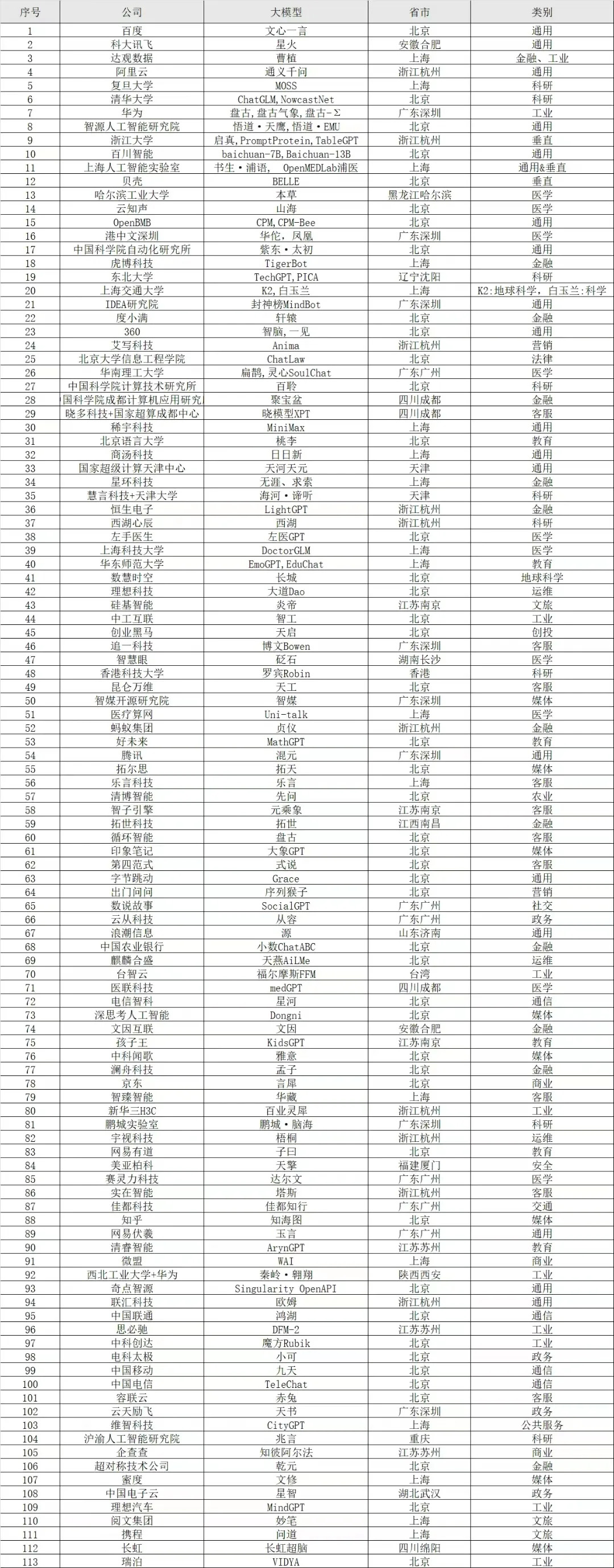

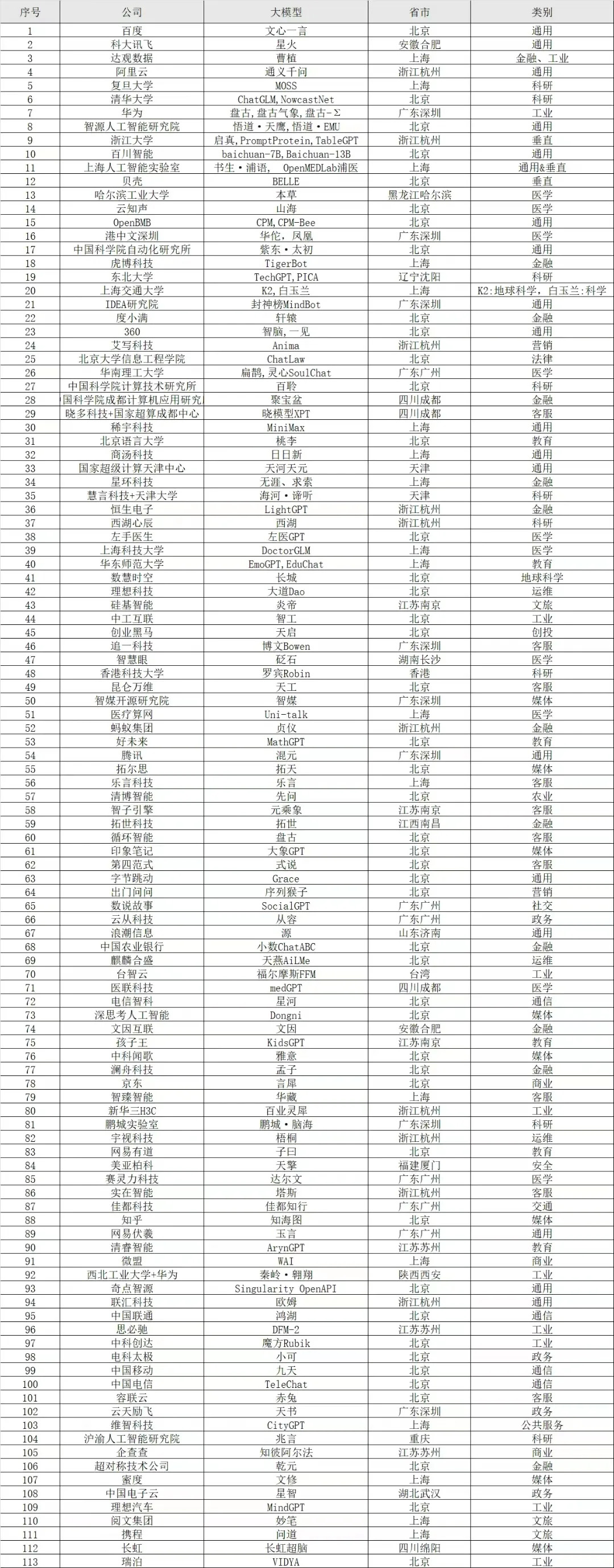

国产大模型大全(113家 来源SuperCLUE)

GPT大模型参数对比

GPT大模型参数对比

| 模型 |

参数量 |

能力 |

训练过程 |

特点 |

| GPT-4 |

1-1.7万亿 |

文本和图像,文本输出(支持编程绘图) |

未指明 |

在各项任务上表现更好GPT3.5,集合了WebGPT和CodeX的优点 |

| GPT-3.5(InstructGPT和ChatGPT) |

1750亿 |

文本输入/输出 |

Alignment概念,SFT,RLHF(RW+PPO) |

指定的训练流程,Alignment概念 |

| GPT-3 |

1750亿 |

文本输入/输出 |

提出in-context learning(0/few-shot) |

对GPT-4的重要参考,影响了其发展 |

| GPT-2 |

15亿 |

文本输入/输出 |

无监督预训练,面向任务的微调 |

泛化性有限,微调需要数据 |

| GPT-1 |

11.7亿 |

文本输入/输出 |

无监督预训练,面向任务的微调 |

泛化性有限,微调需要数据 |

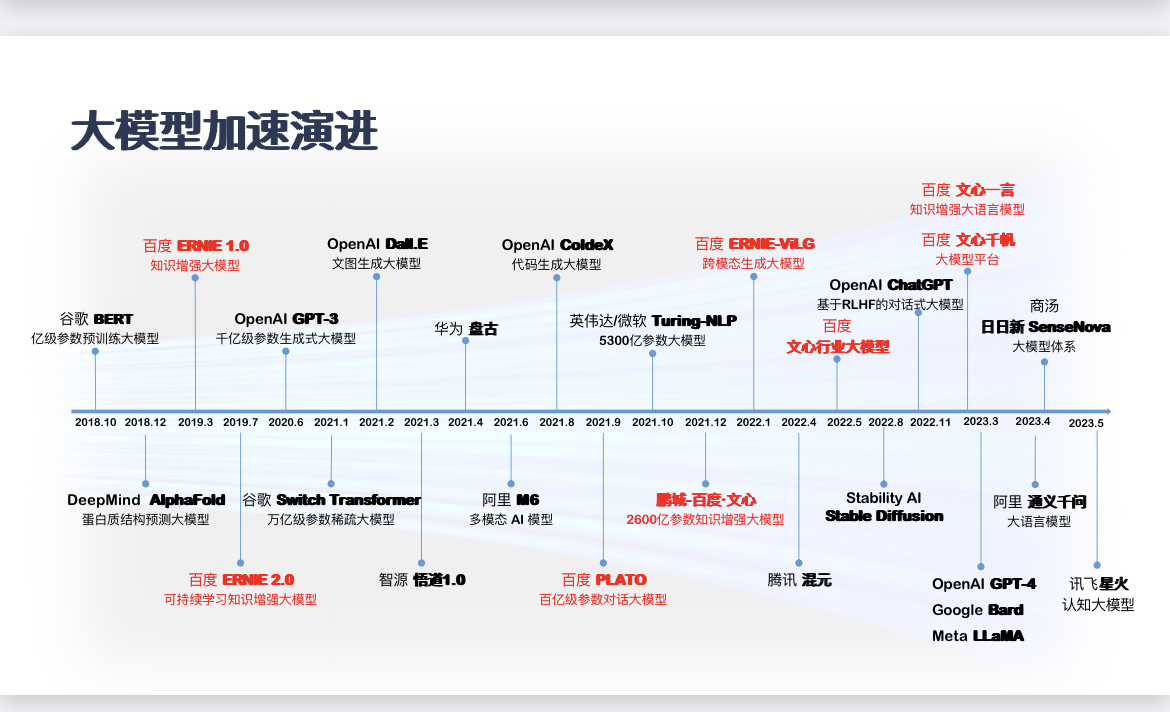

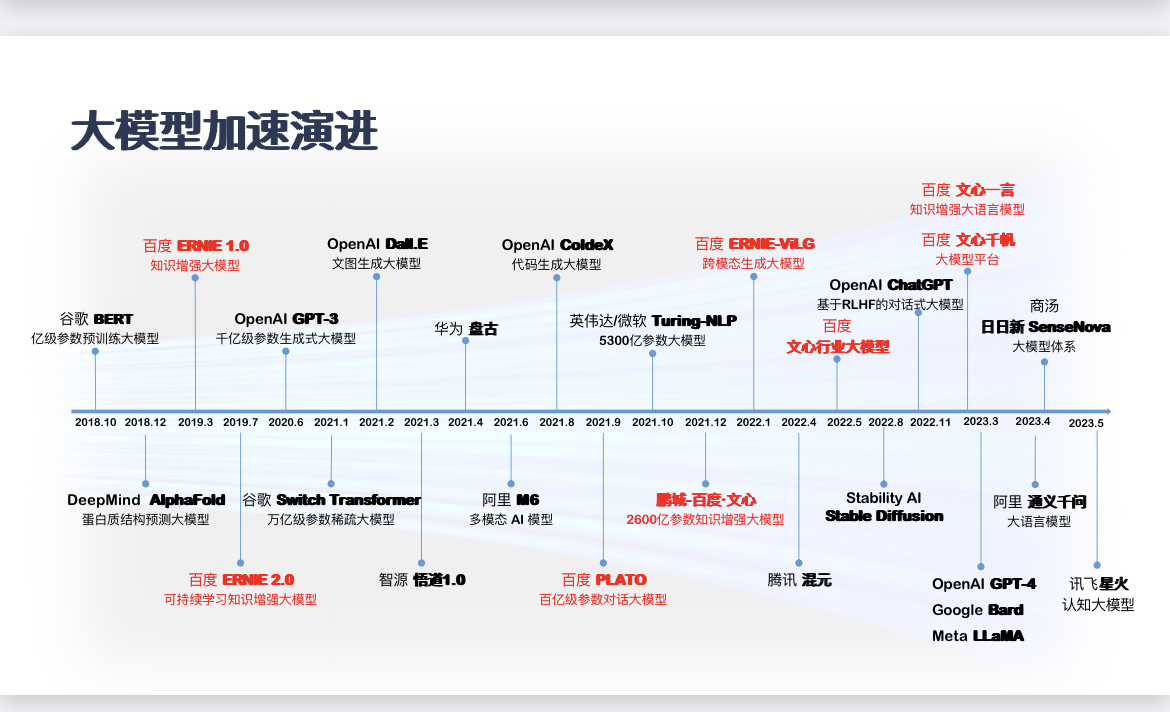

GPT大模型加速演进

GPT大模型时间轴

GPT大模型时间轴

| 年份 |

事件 |

模型 |

参数规模 |

| 2017 |

提出Transformer架构 |

- |

- |

| 2018 |

谷歌提出BERT |

BERT |

30亿 |

| 2018 |

OpenAI提出GPT |

GPT |

- |

| 2019 |

OpenAI发布GPT-2 |

GPT-2 |

150亿 |

| 2019 |

英伟达发布Megatron-LM(83亿参数) |

Megatron-LM |

83亿 |

| 2019 |

谷歌发布T5(110亿参数) |

T5 |

110亿 |

| 2019 |

微软发布Turing-NLG(170亿参数) |

Turing-NLG |

170亿 |

| 2020 |

OpenAI发布GPT-3(1750亿参数) |

GPT-3 |

1750亿 |

| 2020 |

微软和英伟达发布MegatronTuring(5300亿参数) |

MegatronTuring |

5300亿 |

| 2021 |

谷歌发布Switch Transformer(1.6万亿参数) |

Switch Transformer |

1.6万亿 |

| 2021 |

谷歌发布GLaM(1.2万亿参数) |

GLaM |

1.2万亿 |

| 2022 |

商汤发布INTERN(100亿参数) |

INTERN |

100亿 |

| 2021 |

华为云和北京大学发布盘古NLP(1000亿参数) |

盘古 NLP |

1000亿 |

| 2021 |

阿里达摩院发布PLUG(270亿参数) |

PLUG |

270亿 |

| 2021 |

百度发布ERNIE 3.0(百亿参数) |

ERNIE 3.0 |

百亿 |

| 2021 |

浪潮信息发布“源1.0”(约2500亿参数) |

源1.0 |

约2500亿 |

| 2021 |

百度发布ERNIE 3.0 Titan(2600亿参数) |

ERNIE 3.0 Titan |

2600亿 |

| 2022 |

达摩院发布M6(10万亿参数) |

M6 |

10万亿 |

| 2022 |

八卦炉完成建立(174万亿参数) |

八卦炉 |

174万亿 |

| 模型 |

描述 |

用途 |

训练数据来源 |

支持语言 |

费用 |

开源 |

| Word2Vec |

用于单词嵌入的模型 |

单词嵌入、词义相似度等 |

大规模文本数据 |

多种语言 |

免费 |

是 |

| BERT |

Google开发的预训练语言模型 |

用于自然语言处理任务,如情感分析、命名实体识别等 |

大规模文本数据 |

多种语言 |

免费 |

是 |

| GPT-3 |

OpenAI开发的大型预训练语言模型 |

自然语言处理、对话系统、文本生成等 |

大规模文本数据 |

多种语言 |

商业用途需要支付费用 |

是 |

| GPT-4 |

OpenAI发布的进一步改进的语言模型 |

自然语言处理、对话系统、文本生成等 |

大规模文本数据 |

多种语言 |

商业用途需要支付费用 |

是 |

开源大模型

| 模型名称 |

描述 |

用途 |

训练数据来源 |

支持语言 |

费用 |

开源 |

| ChatGLM-6B |

清华大学开发的中英双语对话语言模型 |

商业使用需许可(ChatGLM2-6B) |

未指定 |

中文和英文 |

未提供 |

未提供 |

| GLM-10B/130B |

双语稠密模型 |

未提供 |

未指定 |

中文和英文 |

未提供 |

未提供 |

| OPT-2.7B/13B/30B/66B |

Meta开源的预训练语言模型 |

未提供 |

未指定 |

多种语言 |

未提供 |

未提供 |

| LLaMA-7B/13B/30B/65B |

Meta的基础大语言模型 |

未提供 |

未指定 |

多种语言 |

未提供 |

未提供 |

| Alpaca (LLaMA-7B) |

斯坦福提出的指令跟随模型 |

主要用于英语任务 |

英语数据 |

英语 |

未提供 |

未提供 |

| BELLE (BLOOMZ-7B/LLaMA-7B/LLaMA-13B) |

通过ChatGPT数据优化的中文模型 |

未提供 |

来自ChatGPT的数据(英文) |

英文和中文 |

未提供 |

未提供 |

| Bloom-7B/13B/176B |

支持46种语言的模型,包括法语、汉语、越南语等 |

英语和其他语言 |

xP3数据集微调 |

46种语言 |

未提供 |

未提供 |

| Vicuna (7B/13B) |

由加州大学伯克利分校、卡耐基梅隆大学、斯坦福大学和加州圣地亚哥分校的研究人员开发,与ChatGPT和Bard竞争力 |

未提供 |

通过ShareGPT用户共享对话数据微调 |

英语 |

300美元(Vicuna-13B) |

未提供 |

| FastChat |

用于基于大语言模型的聊天机器人训练、服务和评估的开放平台 |

N/A |

N/A |

N/A |

N/A |

是 |

| Baize(多种模型) |

基于LLaMA的英语和专业医疗模型,未来计划推出中文模型 |

用于研究/非商业用途 |

来自LLaMA和专业领域 |

英语和计划中的中文 |

未提供 |

是 |

| LLMZoo(凤凰、Chimera等) |

香港中文大学和深圳大数据研究院团队开发的大型模型 |

未提供 |

未指定 |

N/A |

未提供 |

未提供 |

| MOSS |

由复旦NLP团队推出的大型语言模型 |

未提供 |

未指定 |

中文和英文 |

未提供 |

未提供 |

| Baichuan-7B |

百川智能发布的商业可用大型模型 |

商业使用可允许 |

中文和英文 |

未提供 |

未提供 |

未提供 |

| CPM-Bee |

开源的百亿参数中英双语基座模型 |

商业使用可允许 |

中文和英文 |

未提供 |

是 |

未提供 |